Évangile : Comment Israël utilise l’IA pour choisir les cibles des bombardements à Gaza

Par Harry Davies, Bethan McKernan et Dan Sabbagh, The Guardian, 1er décembre 2023

Texte original en anglais – [Traduction : Maya Berbery ; révision : Claire Lalande]

L’« usine » axée sur les données, qui accroît considérablement le nombre de cibles pour les frappes en territoire palestinien, soulève des inquiétudes.

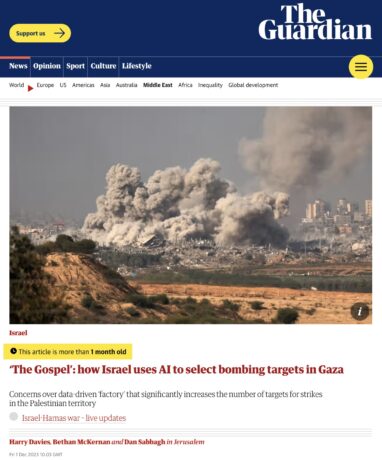

L’armée israélienne ne cherche pas à cacher l’intensité de ses bombardements sur la bande de Gaza. Au début de l’offensive, le chef de l’armée de l’air israélienne parlait de frappes aériennes incessantes, « 24 heures sur 24 ». Ses forces, disait-il, frappent uniquement des cibles militaires mais, ajoutait-il, « sans précision chirurgicale ».

Les méthodes utilisées par les Forces de défense israéliennes (FDI) pour sélectionner les cibles à Gaza et le rôle joué par l’intelligence artificielle dans la campagne de bombardements ont toutefois suscité relativement peu d’attention.

Alors qu’Israël reprend son offensive après un cessez-le-feu de sept jours, on s’inquiète de plus en plus de la méthode de ciblage employée par les FDI dans la guerre contre le Hamas qui, selon le ministère de la Santé de la bande de Gaza dirigée par le Hamas, a déjà tué plus de 15 000 personnes dans le territoire.

L’armée israélienne se taille depuis longtemps une réputation de prouesses techniques et a déjà fait des déclarations audacieuses, mais invérifiables, sur l’utilisation des nouvelles technologies. Après la guerre de 11 jours à Gaza en mai 2021, des responsables ont déclaré qu’Israël avait mené sa « première guerre par IA », une guerre prenant appui sur l’apprentissage automatique et l’informatique de pointe.

Cette dernière guerre entre Israël et le Hamas a offert aux FDI une occasion sans précédent d’utiliser ces outils sur un théâtre d’opérations beaucoup plus vaste et, notamment, de déployer une plateforme de création de cibles par IA appelée Évangile – cette plateforme a sensiblement accéléré une chaîne meurtrière de production de cibles que les responsables comparent à une « usine ».

Grâce à des entretiens auprès de sources du renseignement et à des déclarations peu remarquées faites par les FDI et par des responsables à la retraite, The Guardian est maintenant en mesure de révéler de nouveaux détails sur Évangile et sur son rôle central dans la guerre d’Israël à Gaza.

Notre article s’appuie aussi sur des témoignages parus dans la publication israélo-palestinienne +972 Magazine et sur le site de nouvelles en hébreu Local Call, deux médias ayant interviewé plusieurs sources actuelles et anciennes du milieu du renseignement israélien qui connaissent la plateforme Évangile.

Leurs commentaires donnent un premier aperçu des rouages d’une unité secrète du renseignement militaire guidé par l’IA, qui tient un rôle important dans la riposte israélienne au massacre perpétré par le Hamas dans le sud d’Israël le 7 octobre.

L’emploi de l’IA par l’armée israélienne commence à paraître au grand jour au moment où l’on s’inquiète de plus en plus des risques pour les populations civiles posés par l’utilisation accrue, sur les champs de bataille, de systèmes automatisés complexes et opaques par les forces armées avancées du monde entier.

« D’autres États vont observer ce qui se passe et en tirer des leçons », a déclaré un ancien responsable de la sécurité à la Maison-Blanche qui connaît bien l’utilisation des systèmes autonomes par l’armée des États-Unis.

La guerre entre Israël et le Hamas, dit-il, pourrait représenter « un moment clé si les FDI utilisent l’IA de manière significative pour la sélection des cibles, avec des conséquences de vie ou de mort ».

De 50 cibles par année à 100 cibles par jour

Au début de novembre, les FDI ont soutenu que leur division d’administration des cibles avait identifié « plus de 12 000 » cibles à Gaza.

« Nous ne faisons pas de compromis pour définir l’ennemi. Les agents du Hamas ne sont pas à l’abri, peu importe où ils se cachent », a affirmé un responsable décrivant le processus de ciblage de la division.

Les activités de la division, créée en 2019 au sein de la direction du renseignement des FDI, sont classifiées.

Cependant, dans un bref énoncé sur leur site Web, les FDI ont déclaré utiliser un système basé sur l’IA appelé Habsora (Évangile en français) dans la guerre contre le Hamas pour « générer des cibles à un rythme rapide ».

Selon les FDI, « grâce à l’extraction rapide et automatique de renseignements », Évangile recommande des cibles à ses chercheurs « avec pour objectif une correspondance parfaite entre la recommandation de la machine et l’identification effectuée par un être humain ».

De multiples sources qui connaissent les méthodes de ciblage des FDI ont confirmé l’existence d’Évangile à +972/Local Call, affirmant que cet outil a été employé pour produire des recommandations automatisées de cibles d’attaque, notamment les domiciles de personnes soupçonnées d’être actives au sein du Hamas ou du Djihad islamique.

Ces dernières années, la division d’administration des cibles a aidé les FDI à constituer une base de données de 30 000 à 40 000 militant-e-s présumés, selon des sources qui ont affirmé que des systèmes comme Évangile ont joué un rôle essentiel dans l’établissement des listes d’individus autorisés à être assassinés.

Aviv Kochavi, qui a dirigé les FDI jusqu’en janvier, a déclaré que la division d’administration des cibles est « alimentée par IA » et compte des centaines de militaires de tous rangs.

Dans une entrevue publiée avant la guerre, il a expliqué que cette « machine produit de grandes quantités de données plus efficacement que n’importe quel humain et traduit ces données en cibles d’attaque ».

« Une fois activée » lors de la guerre de 11 jours entre Israël et le Hamas en mai 2021, cette machine générait 100 cibles par jour. « Pour mettre cela en perspective, dans le passé, nous produisions 50 cibles par an à Gaza. Aujourd’hui, cette machine génère 100 cibles par jour, dont 50 % sont attaquées.

On ne sait pas exactement quelles formes de données sont employées par Évangile. Mais, selon les spécialistes, les systèmes d’aide à la décision axés sur l’IA pour le ciblage analysent généralement de grands ensembles d’informations provenant d’un éventail de sources : images de drones, communications interceptées, données de surveillance, renseignements tirés de la surveillance des mouvements réels et des modèles de comportement d’individus et de grands groupes.

La division de l’administration des cibles a été créée pour résoudre un problème chronique au sein des FDI : lors des opérations précédentes à Gaza, l’armée de l’air s’est trouvée à plusieurs reprises à court de cibles à frapper. Comme les hauts responsables du Hamas disparaissaient dans les tunnels au début de toute nouvelle offensive, des systèmes comme Évangile permettaient aux FDI de localiser et d’attaquer un nombre beaucoup plus important d’agents subalternes.

Un responsable, qui a pris part aux décisions de ciblage lors d’opérations passées à Gaza, a déclaré que, auparavant, les FDI ne ciblaient jamais les maisons des membres subalternes du Hamas pour les bombarder. Selon lui, il en va autrement dans le conflit actuel, les maisons des membres présumés du Hamas étant désormais visées, quel que soit le rang de ces membres.

« Ça fait beaucoup de maisons », a déclaré ce responsable à +972/Local Call. « Les membres du Hamas qui n’ont aucune importance vivent dans des maisons partout à Gaza. Alors, les FDI marquent la maison, la bombardent et tuent toutes les personnes qui s’y trouvent ».

Les cibles sont « cotées » en fonction du nombre probable de victimes civiles

Dans la brève déclaration des FDI sur leur division d’administration des cibles, un haut responsable a affirmé que l’unité « permet des attaques précises sur les infrastructures associées au Hamas qui causent des dommages considérables à l’ennemi et des dommages minimes aux non-combattants ».

De nombreux reportages dans les médias israéliens insistent sur la précision des frappes recommandées par la « banque de cibles de l’IA ». Le quotidien Yedioth Ahronoth a rapporté que la division « veille à limiter autant que possible les dommages pour les civils non impliqués ».

Un ex-responsable militaire israélien de haut rang a déclaré à The Guardian que les agents utilisent une mesure « très précise » du taux de civil-e-s qui évacuent un bâtiment juste avant une frappe. « Nous utilisons un algorithme pour évaluer le nombre de civils restants. L’algorithme nous donne alors une cote : vert, jaune, rouge, comme un feu de circulation. »

Toutefois, les spécialistes en IA et en conflits armés qui se sont entretenus avec The Guardian se sont montrés sceptiques quant aux affirmations selon lesquelles les systèmes axés sur l’IA réduiraient les dommages causés aux civil-e-s grâce à un ciblage plus précis.

Selon un avocat qui conseille les gouvernements sur l’IA et le respect du droit humanitaire, il y a « peu de preuves empiriques » à l’appui de ces affirmations. D’autres ont souligné l’impact visible des bombardements.

« Regardez le paysage physique de Gaza », dit Richard Moyes, un chercheur qui dirige Article 36, un groupe militant pour la réduction des dommages causés par les armes.

« Nous voyons l’aplanissement d’une zone urbaine entière par des armes explosives lourdes, de sorte que l’affirmation voulant que la force exercée soit précise et finement ciblée n’est pas corroborée par les faits. »

Selon les chiffres publiés par les FDI en novembre, au cours des 35 premiers jours de la guerre, Israël a attaqué 15 000 cibles à Gaza, un chiffre considérablement plus élevé que lors des opérations militaires précédentes dans ce territoire côtier densément peuplé. À titre de comparaison, lors de la guerre de 2014, qui avait duré 51 jours, les FDI avaient frappé entre 5 000 et 6 000 cibles.

De multiples sources ont déclaré à The Guardian et à +972/Local Call que lorsqu’une frappe est autorisée sur les domiciles d’individus identifiés comme des agents du Hamas ou du Djihad islamique, les personnes affectées à la recherche de cibles connaissent à l’avance le nombre de civils susceptibles d’être tués.

À chaque cible, ont-elles dit, correspond un dossier contenant une cote de dommages collatéraux indiquant le nombre de victimes civiles potentielles pour la frappe.

Selon une source qui a travaillé jusqu’en 2021 à la planification des frappes pour les FDI, « la décision de frappe est prise par la personne commandant l’unité en service », dont certaines sont plus enclines que d’autres à avoir « la gâchette facile ».

Il est arrivé qu’« une cible soulève des doutes » et « nous avons alors tué ce que je pense être un nombre disproportionné de civils », a reconnu cette source.

Un porte-parole de l’armée israélienne a déclaré : « En réponse aux attaques barbares du Hamas, les FDI s’emploient à démanteler les capacités militaires et administratives du Hamas. Contrairement aux attaques intentionnelles du Hamas contre des hommes, des femmes et des enfants israéliens, les FDI respectent le droit international et prennent les précautions nécessaires pour atténuer les dommages causés aux civils. »

« Une usine d’assassinats de masse »

Des sources familières avec les modes d’intégration des systèmes basés sur l’IA aux opérations des FDI ont affirmé que ces outils ont considérablement accéléré le processus de création des cibles.

« Nous préparons les cibles automatiquement et nous travaillons à partir d’une liste de contrôle », a déclaré à +972/Local Call une source qui a déjà fait partie de la division d’administration des cibles. « C’est vraiment comme une usine. Nous travaillons rapidement et nous n’avons pas le temps de bien analyser chaque cible. Nous sommes jugés en fonction du nombre de cibles que nous parvenons à générer. »

Une autre source a déclaré à la publication qu’Évangile avait permis aux FDI de gérer une « usine d’assassinats de masse » qui « met l’accent sur la quantité et non sur la qualité ». Un œil humain, a-t-elle ajouté, « passera en revue les cibles avant chaque attaque, mais sans y consacrer beaucoup de temps ».

Pour certains spécialistes de l’IA et du droit international humanitaire, une telle accélération est inquiétante.

Marta Bo, chercheuse à l’Institut international de recherche sur la paix de Stockholm, soutient que même lorsque « des êtres humains prennent part au processus », elles et ils courent le risque de développer un « biais d’automatisation » et de « trop compter sur des systèmes qui, dès lors, en viennent à exercer une influence indue sur des décisions humaines complexes ».

Richard Moyes, de l’organisation Article 36, décrit ainsi l’utilisation des outils comme Évangile : le commandement « se voit remettre une liste de cibles générée par un ordinateur sans nécessairement savoir comment la liste a été créée ou sans avoir la capacité de mettre en doute ou de remettre en question les recommandations de ciblage de manière adéquate ».

« Plus les êtres humains s’en remettent à ces systèmes, plus ils risquent de se transformer en rouages d’un processus mécanisé et de perdre la capacité de juger de manière significative les dommages potentiels aux civils », a-t-il ajouté.